正态分布详解

正态分布(Normal Distribution),又叫高斯分布(Gaussian Distribution),它不仅是重要,它简直就是概率论里的**"神"**。

在数学家眼里,它是上帝创造世界时留下的"指纹"。 在深度学习里,它是所有模型"出生"和"呼吸"的空气。

我们分三个层面把这个"神"请下神坛,看看到底是怎么回事。

一、长相:那口"钟" (The Bell Curve)

正态分布长得非常漂亮,就是一条完美的钟形曲线。

- 中间高:代表大多数人都凑在中间(平均水平)。

- 两边低:代表极好和极坏的人都是少数。

- 左右对称:比平均好一点的人数,和比平均差一点的人数是一样的。

概率密度函数

只有两个"旋钮"控制它

不管这口钟在哪,或者长什么样,只由两个参数决定(就像深度学习里的超参数):

1. 位置参数 (均值 / Mu)

- 决定钟峰在哪里。

- 变大,整个钟往右移; 变小,往左移。

- 例子:全班平均分是80,那钟的最高点就在80。

2. 形状参数 (标准差 / Sigma)

- 决定钟是胖还是瘦。

- 大(方差大):钟很扁平。代表大家差距很大,什么人都有。(数据不稳定)

- 小(方差小):钟很尖瘦。代表大家都挤在一起,差别不大。(数据很集中)

| 参数 | 作用 | 变大时 | 变小时 |

|---|---|---|---|

| 位置 | 钟往右移 | 钟往左移 | |

| 形状 | 钟变扁平 | 钟变尖瘦 |

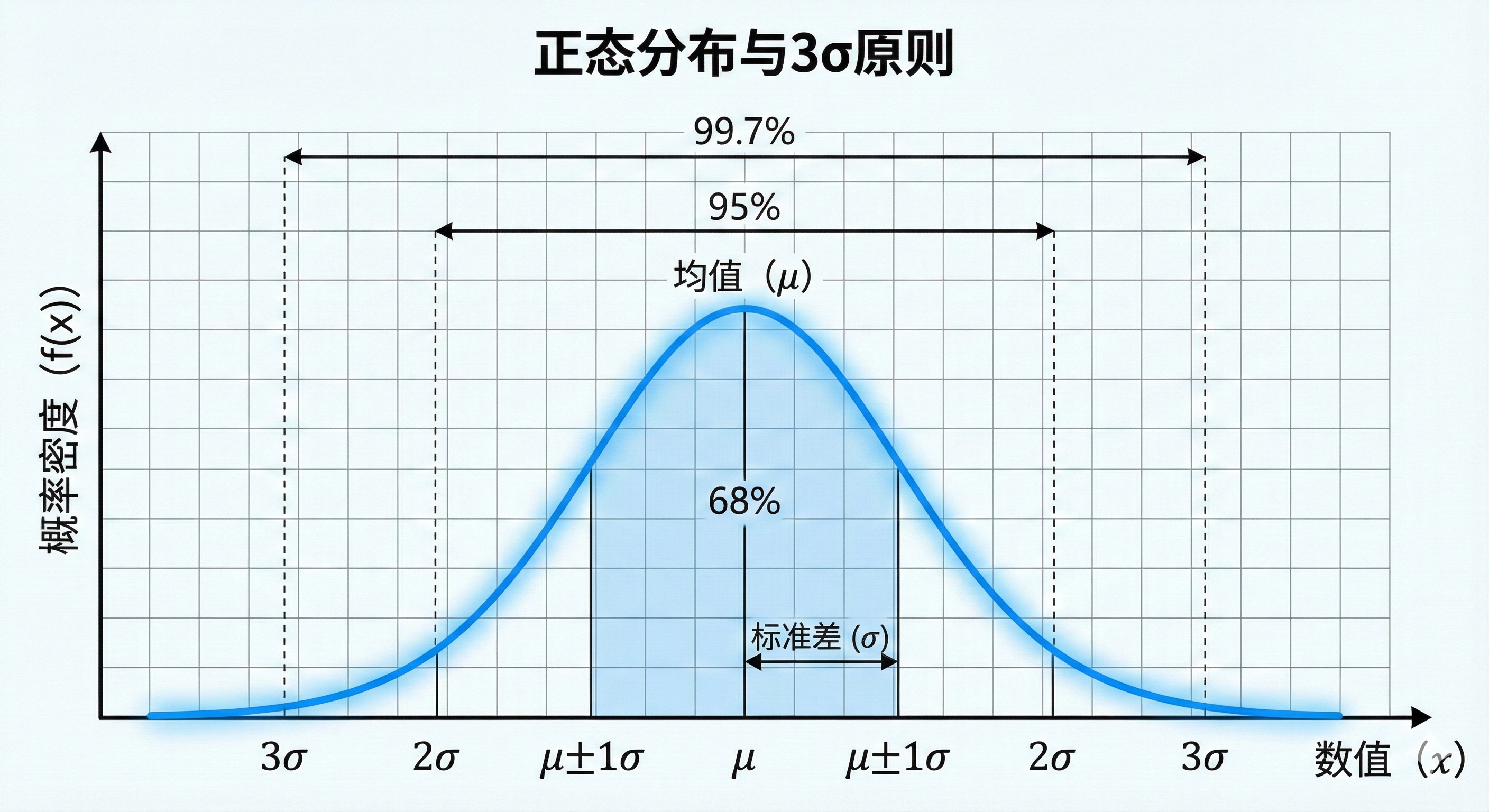

二、核心法则:3σ 原则 (The 3-Sigma Rule)

这是正态分布最实用的地方,特别是在异常检测和工业质检中。记住这三个数字,你就能看透数据的分布:

| 范围 | 覆盖比例 | 含义 |

|---|---|---|

| 68.27% | 普通大众 | |

| 95.45% | 绝大多数人 | |

| 99.73% | 超过这个范围的就是妖孽(异常值) |

深度学习应用

如果你的数据预处理没做好,某个特征的值跑到了 3σ 之外,这个数据点可�能会把你的梯度"带偏",导致模型训练不收敛。所以我们经常要切除异常值(Outliers)。

import numpy as np

# 检测异常值(超过 3σ 的数据)

def detect_outliers(data):

mean = np.mean(data)

std = np.std(data)

outliers = data[(data < mean - 3*std) | (data > mean + 3*std)]

return outliers

# 移除异常值

def remove_outliers(data):

mean = np.mean(data)

std = np.std(data)

return data[(data >= mean - 3*std) & (data <= mean + 3*std)]

三、为什么它这么重要?(哲学层面)

你可能会问:"凭什么说它是上帝的指纹?别的分布不行吗?"

这就回到了中心极限定理 (CLT)。

自然界的规律

只要一个事情的结果,是由无数个微小的、独立的随机因素共同累加造成的,那它最终一定服从正态分布。

| 现象 | 影响因素 | 结果 |

|---|---|---|

| 身高 | 基因、营养、睡眠、运动... | 正态分布 |

| 考试成绩 | 智商、努力、心态、运气、字迹... | 正态分布 |

| 测量误差 | 手抖、尺子热胀冷缩、光线折射... | 正态分布 |

| 股票日收益 | 无数买卖决策叠加 | 近似正态分布 |

结论:因为世界太复杂了,大部分事情都是多因素叠加的,所以正态分布是宇宙中最普遍的形态。

四、为什么深度学习离不开它?(实战层面)

你在写 torch 代码时,正态分布无处不在,原因主要有三点:

1. 初始化的起点 (torch.randn)

当你定义一个 nn.Linear 层时,权重 怎么给初值?

- 不能全是 0(那就没法学习了,对称性破不掉)

- 也不能全是 1(信号会爆炸)

通常我们用标准正态分布 或者其变体(如 Xavier/Kaiming 初始化)来生成随机数。

原因:正态分布让参数有正有负,且集中在 0 附近。这保证了信号传下去的时候,既不会爆炸(变得无穷大),也不会消失(变成0)。

import torch

# 标准正态分布初始化

W = torch.randn(784, 256) # 从 N(0,1) 采样

# Kaiming 初始化(适用于 ReLU)

nn.init.kaiming_normal_(layer.weight)

2. 标准化 (BatchNorm / LayerNorm)

你用的 nn.BatchNorm2d,做的事情就是:暴力把数据"扭"回正态分布。

原因:神经网络最喜欢吃正态分布的数据(均值0,方差1)。如果不归一化,数据这一批是 10000,下一批是 0.001,网络这就疯了,根本学不动。

import torch.nn as nn

# BatchNorm 强制把数据变回 N(0,1) 附近

bn = nn.BatchNorm1d(256)

normalized = bn(features) # 输出近似 N(0,1)

3. 生成模型的灵魂 (VAE / Diffusion)

现在最火的 AI 画图(Stable Diffusion):

- 它的起点就是一张纯粹的高斯噪声图(就是电视机没信号时的雪花屏,每个像素点都服从正态分布)。

- AI 的工作就是把这个杂乱无章的正态分布,一步步"雕刻"成有意义的图片分布。

- 如果没有正态分布作为数学基础,AI 根本不知道从哪里开始画。

import torch

# Diffusion 模型的起点:纯高斯噪声

noise = torch.randn(1, 3, 512, 512) # 一张 512x512 的噪声图

# 模型学习的是:如何从噪声逐步还原出图片

for t in reversed(range(1000)):

noise = denoise_step(noise, t) # 每一步都在"雕刻"

五、标准正态分布

当 , 时,我们称之为标准正态分布。

为什么它是"标准"?

任何正态分布都可以通过标准化变换转化为标准正态分布:

这就是为什么我们只需要一张标准正态分布表,就能查所有正态分布的概率。

深度学习中的地位

标准正态分布 在深度学习中几乎是"默认设置":

| 场景 | 使用 N(0,1) 的原因 |

|---|---|

| 权重初始化 | 保证信号稳定传播 |

| 数据标准化 | 特征平等,加速收敛 |

| BatchNorm 输出 | 保持激活值在合理范围 |

| VAE 潜在空间 | 便于采样和插值 |

| Diffusion 噪声 | 数学性质好,易于建模 |

六、总结

正态分布之所以重要,是因为它是秩序的代表。

| 层面 | 正态分布的意义 |

|---|---|

| 形状 | 完美的钟形曲线 |

| 物理意义 | 无数微小因素叠加的必然结果 |

| 数学性质 | 可加性、对称性、最大熵 |

| 深度学习 | 初始化、标准化、生成模型的基石 |

只要你假设数据是"讲道理"的、是"自然"的,你其实就是�在假设它服从正态分布。

现在,你是不是觉得 torch.randn() 这一行代码看起来亲切多了?它其实是在模拟大自然的混沌。